Le caratteristiche principali di Llama 4 di Meta spiegate in dettaglio

Llama 4 rappresenta un modello di intelligenza artificiale multimodale capace di elaborare testo e immagini in modo integrato. Questo approccio innovativo migliora l’accessibilità e l’efficienza per utenti di tutto il mondo. A differenza di modelli precedenti, come GPT-3 o Llama 2, Llama 4 si distingue per una maggiore inclusività linguistica. Ad esempio, solo lo 0,11% dei dati di addestramento di Llama 2 era in italiano, mentre Llama 4 punta a una distribuzione più equilibrata. Grazie alla sua filosofia open source, Llama 4 A stabilisce un nuovo standard per lo sviluppo collaborativo nell’IA.

Punti Chiave

Llama 4 è un’intelligenza artificiale che usa testo e immagini. Aiuta gli utenti a lavorare in modo più veloce.

Llama 4 è open source, quindi tutti possono usarlo. Questo favorisce il lavoro insieme tra aziende e sviluppatori.

La struttura ‘Mixture of Experts’ di Llama 4 usa meglio le risorse. Così funziona bene e inquina meno.

Può leggere fino a 10 milioni di parole. Questo aiuta a capire meglio testi difficili.

Llama 4 è utile in molti campi, come supporto clienti, studio di documenti e scrittura di testi.

Panoramica di Llama 4 e la sua evoluzione

Innovazioni rispetto a Llama 3

Llama 4 rappresenta un significativo passo avanti rispetto al suo predecessore, Llama 3.2. La nuova versione introduce un’architettura completamente riprogettata, basata sul concetto di “Mixture of Experts,” che migliora l’efficienza e la precisione. A differenza di Llama 3.2, che si limitava a elaborare testo, Llama 4 supporta anche immagini e video, offrendo un’integrazione fluida tra i diversi formati.

Ecco un confronto tra i due modelli:

Modello | Architettura | Capacità Multimodali | Prestazioni Superiori | Benchmark Superati |

|---|---|---|---|---|

Llama 4 Scout | Mixture of Experts | Sì | Sì | GPT-4o, Gemini 2.0 |

Llama 4 Maverick | Mixture of Experts | Sì | Sì | GPT-4o, Gemini 2.0 |

Llama 3.2 | Architettura Simile | No | No | N/A |

Questi miglioramenti rendono Llama 4 un modello più versatile e competitivo, capace di superare i benchmark di modelli come GPT-4o e Gemini 2.0.

Obiettivi principali di Meta con Llama 4

Meta ha sviluppato Llama 4 con l’obiettivo di creare un’intelligenza artificiale open source accessibile a tutti. Questo approccio promuove l’uso diffuso della tecnologia e incoraggia la collaborazione tra sviluppatori e aziende.

Gli obiettivi principali includono:

Sintesi di documenti complessi, come dimostrato dal modello Scout.

Analisi personalizzata delle attività degli utenti.

Capacità di ragionare su ampie basi di codice.

Llama 4 Scout, ad esempio, è ottimizzato per funzionare su una singola GPU NVIDIA H100, offrendo una finestra di contesto di 10 milioni di token. Questo lo rende ideale per applicazioni avanzate, superando modelli concorrenti in vari benchmark.

Llama 4 A: un nuovo standard per l’IA open source

Llama 4 A stabilisce un nuovo standard per l’intelligenza artificiale open source. Questo modello combina potenza e accessibilità, rendendolo una risorsa preziosa per sviluppatori e ricercatori. La sua capacità di elaborare simultaneamente testo, immagini e video lo distingue nel panorama dell’IA.

Meta ha presentato Llama 4 A come il modello multimodale migliore della categoria. La sua architettura avanzata e le prestazioni superiori lo rendono una scelta ideale per applicazioni educative, industriali e di ricerca. Grazie alla filosofia open source, Llama 4 A favorisce l’innovazione e la collaborazione globale.

I modelli principali di Llama 4

Scout: efficienza e scalabilità

Scout rappresenta il modello più leggero e ottimizzato della famiglia Llama 4. Progettato per garantire efficienza e scalabilità, questo modello si adatta perfettamente a sistemi con risorse limitate. La sua finestra di contesto, che raggiunge i 10 milioni di token, consente di elaborare grandi quantità di dati in modo rapido e preciso.

Le prestazioni di Scout sono state testate su benchmark come:

HellaSwag: per valutare la capacità di completare frasi seguendo il buon senso umano.

GSM8K: per misurare l’abilità nel risolvere problemi matematici complessi.

IFEval: un benchmark innovativo che verifica la capacità di seguire istruzioni dettagliate.

Grazie alla sua architettura “Mixture of Experts,” Scout offre un’inferenza economica senza compromettere la precisione. Questo lo rende ideale per applicazioni aziendali e progetti di ricerca con budget limitati.

Maverick: equilibrio tra prestazioni e versatilità

Maverick si posiziona come il modello più versatile della serie Llama 4. Con una finestra di contesto di 1 milione di token, Maverick bilancia prestazioni elevate e flessibilità. È stato progettato per gestire una vasta gamma di applicazioni, dalla sintesi di documenti complessi all’analisi di dati multimodali.

I test su benchmark come HellaSwag e IFEval dimostrano la sua capacità di adattarsi a scenari diversi. Maverick eccelle anche nell’elaborazione di immagini e testo, rendendolo una scelta ideale per sviluppatori che cercano un modello completo e affidabile.

Behemoth: potenza per applicazioni complesse

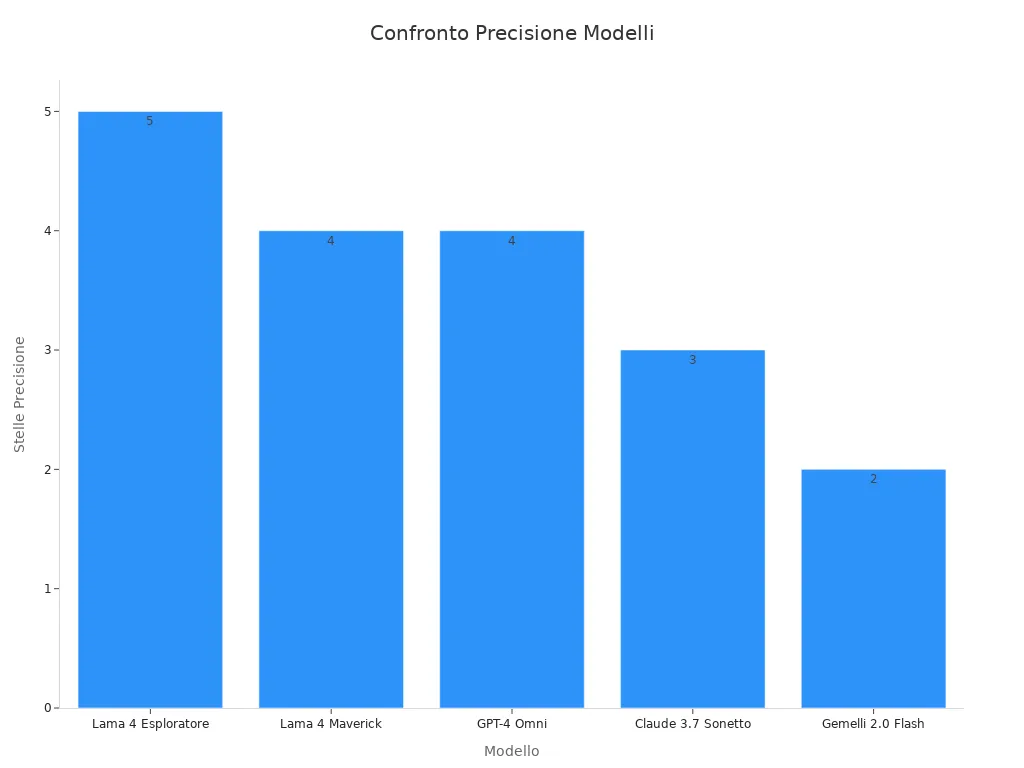

Behemoth rappresenta il modello più potente della famiglia Llama 4. Progettato per applicazioni complesse, offre una precisione senza pari grazie alla sua architettura avanzata. La tabella seguente confronta Behemoth con altri modelli di intelligenza artificiale:

Modello | Finestra di contesto | Multimodalità | Inferenza economica | Open Source | Precisione (parametri di riferimento) |

|---|---|---|---|---|---|

Llama 4 Scout | 10 milioni di token | ✅ | ✅ | ✅ | ⭐⭐⭐⭐⭐ |

Llama 4 Maverick | 1 milione di token | ✅ | ✅ | ✅ | ⭐⭐⭐⭐ |

GPT-4 Omni | Token da 128 | ✅ | ❌ | ❌ | ⭐⭐⭐⭐ |

Claude 3.7 Sonetto | Token da 200 | ✅ | ❌ | ❌ | ⭐⭐⭐ |

Gemelli 2.0 Flash | 1 milione di token | ✅ | ❌ | ❌ | ⭐⭐ |

Behemoth si distingue per la sua capacità di gestire applicazioni industriali e scientifiche avanzate. La sua precisione è stata dimostrata in benchmark come IFEval, dove ha superato modelli concorrenti.

Grazie alla sua potenza e alla filosofia open source, Behemoth rappresenta una risorsa fondamentale per progetti innovativi e complessi.

Filosofia open source e benefici per la comunità

Perché Meta ha scelto l’open source

Meta ha adottato un approccio open source per Llama 4 con l’obiettivo di democratizzare l’accesso all’intelligenza artificiale. Questo modello consente a sviluppatori e ricercatori di tutto il mondo di utilizzare e migliorare la tecnologia senza barriere.

Zuckerberg ha dichiarato che l’IA open source rappresenta il futuro, sottolineando la strategia di Meta verso una maggiore trasparenza.

Meta mira a costruire l’IA più importante del mondo, rendendola accessibile a tutti.

Nonostante le preoccupazioni sollevate da alcuni ricercatori sull’uso militare dei modelli Llama, Meta sostiene che l’apertura favorisce lo sviluppo globale.

Questa filosofia riflette la convinzione che la collaborazione internazionale acceleri l’innovazione e riduca le disparità tecnologiche.

Vantaggi per sviluppatori e aziende

L’approccio open source di Llama 4 offre numerosi vantaggi per sviluppatori e aziende. La possibilità di accedere al codice sorgente consente di personalizzare il modello per esigenze specifiche.

“L’open source non solo riduce i costi di sviluppo, ma promuove anche la creatività e l’adattabilità,” affermano gli esperti del settore.

I principali benefici includono:

Riduzione dei costi: Le aziende possono integrare Llama 4 senza investire in licenze costose.

Personalizzazione: Gli sviluppatori possono adattare il modello a settori specifici, come la sanità o l’educazione.

Collaborazione globale: La condivisione di conoscenze tra comunità diverse accelera il progresso tecnologico.

Questi vantaggi rendono Llama 4 una risorsa preziosa per chi cerca soluzioni innovative e sostenibili.

Come contribuire allo sviluppo di Llama 4

Meta incoraggia la comunità globale a partecipare attivamente allo sviluppo di Llama 4. Gli sviluppatori possono contribuire attraverso il miglioramento del codice, la creazione di nuovi dataset e la condivisione di esperienze.

Ecco alcune modalità per partecipare:

Segnalazione di bug: Identificare e risolvere problemi tecnici.

Proposte di miglioramento: Suggerire nuove funzionalità o ottimizzazioni.

Collaborazione su GitHub: Utilizzare la piattaforma per condividere codice e idee.

Questa collaborazione aperta non solo migliora il modello, ma rafforza anche la comunità globale dell’IA. Meta crede che il contributo collettivo sia essenziale per costruire un futuro tecnologico più equo e innovativo.

Innovazioni tecniche di Llama 4

Finestre di contesto estese e loro impatto

Llama 4 introduce finestre di contesto significativamente estese, che migliorano la capacità del modello di gestire grandi quantità di dati. Queste finestre consentono di elaborare fino a 10 milioni di token, un progresso che supera di gran lunga i limiti dei modelli precedenti. La maggiore lunghezza del contesto permette una sintesi più accurata di documenti complessi e una migliore comprensione delle relazioni tra i dati.

Le finestre di contesto estese hanno un impatto diretto su metriche chiave, come mostrato nella tabella seguente:

Metrica | Descrizione |

|---|---|

Lunghezza del contesto | L’efficacia della RAG dipende dalle dimensioni della finestra di contesto. |

Robustezza | Il rumore o le informazioni contraddittorie possono influire sull’output. |

Espansione dei Ruoli dei LLM | I LLM svolgono ruoli cruciali nel recupero e nella valutazione. |

Questi miglioramenti rendono Llama 4 ideale per applicazioni che richiedono analisi approfondite e gestione di dati complessi.

Supporto multimodale: testo e immagini

Llama 4 si distingue per il suo supporto multimodale, che integra testo e immagini in un unico modello. Questa capacità consente agli utenti di interagire con il modello utilizzando input diversificati, migliorando l’accessibilità e l’efficienza. Ad esempio, Llama 4 A utilizza questa tecnologia per analizzare immagini e generare descrizioni dettagliate, rendendolo utile per applicazioni educative e industriali.

Il supporto multimodale apre nuove possibilità per settori come la sanità, dove il modello può analizzare immagini mediche e fornire diagnosi basate su dati testuali. Inoltre, questa innovazione facilita la creazione di contenuti visivi e testuali, offrendo soluzioni versatili per sviluppatori e aziende.

Architettura “mixture of experts” per efficienza e precisione

L’architettura “Mixture of Experts” (MoE) rappresenta uno dei principali avanzamenti tecnici di Llama 4. Questa struttura ottimizza l’uso delle risorse, riducendo l’impatto ambientale e migliorando l’efficienza generale. I benchmark dimostrano la superiorità di questa architettura:

Benchmark | Risultati ottenuti |

|---|---|

MATH-500 | Superato da DeepSeek-R1 in problemi matematici |

SWE-bench | Superato da DeepSeek-R1 nella generazione di codice |

L’architettura MoE offre vantaggi significativi:

Ottimizza l’uso delle risorse computazionali.

Riduce l’impatto ambientale.

Promuove modelli di IA più sostenibili.

Questa innovazione rende Llama 4 un modello all’avanguardia, capace di gestire applicazioni complesse con precisione e sostenibilità.

Confronti con altri modelli di IA

Llama 4 vs GPT-4: differenze chiave

Llama 4 e GPT-4 rappresentano due dei modelli di intelligenza artificiale più avanzati disponibili oggi. Tuttavia, presentano differenze significative che li rendono unici.

Costo di inferenza: Llama 4 offre un costo di inferenza per milione di token tra 8 e 20 volte inferiore rispetto a GPT-4 Omni. Questo lo rende una scelta più economica per aziende e sviluppatori.

Finestra di contesto: Llama 4 supporta finestre di contesto fino a 10 milioni di token, mentre GPT-4 si limita a 128 token. Questa differenza consente a Llama 4 di gestire documenti complessi con maggiore efficienza.

Accessibilità: Llama 4 è completamente gratuito e open source, mentre GPT-4 richiede un abbonamento o un pagamento per l’accesso.

Queste caratteristiche rendono Llama 4 una soluzione più accessibile e versatile, soprattutto per chi cerca un modello potente senza costi elevati.

Confronto con altri modelli open source

Llama 4 si distingue anche rispetto ad altri modelli open source grazie alla sua architettura avanzata e alle sue capacità multimodali. La tabella seguente evidenzia alcune differenze chiave:

Modello | Differenze | Pro e Contro |

|---|---|---|

DeepSeek V3 | Più efficiente, meno accessibile | Pro: Performance in coding e matematica; Costi inferiori. Contro: Interfaccia utente meno sviluppata. |

Llama 3.1 | Modularità vs struttura tradizionale | Pro: Efficienza e specificità nei compiti. Contro: Limitazioni di accesso ai dati. |

GPT-4 | – | Pro: Prestazioni elevate. Contro: – |

Claude 3.5 | Focus su sicurezza vs efficienza | Pro: Velocità di inferenza. Contro: Meno attenzione all’etica. |

Llama 4 supera molti di questi modelli in termini di flessibilità e capacità di elaborare dati complessi, rendendolo una scelta ideale per applicazioni avanzate.

Perché Llama 4 si distingue nel mercato

Llama 4 si distingue nel mercato per la sua combinazione unica di potenza, accessibilità e innovazione tecnica. La sua architettura “Mixture of Experts” ottimizza l’uso delle risorse, riducendo l’impatto ambientale e migliorando l’efficienza.

Inoltre, le sue capacità multimodali, che integrano testo e immagini, aprono nuove possibilità per applicazioni in settori come la sanità, l’educazione e l’industria. La tabella seguente riassume alcune metriche chiave che evidenziano il vantaggio competitivo di Llama 4:

Aspetto | Descrizione |

|---|---|

Velocità | Misura quanto rapidamente un modello può elaborare le informazioni. |

Precisione | Valuta l’accuratezza delle risposte fornite dal modello. |

Capacità di comprensione | Indica quanto bene il modello può interpretare e rispondere a domande complesse. |

Grazie a queste caratteristiche, Llama 4 rappresenta una soluzione rivoluzionaria per chi cerca un modello di IA all’avanguardia e sostenibile.

Applicazioni pratiche e casi d’uso

Utilizzo aziendale e industriale

Llama 4 ha dimostrato di essere uno strumento essenziale per molte aziende e industrie. La sua inferenza è 2,3 volte più veloce rispetto a Llama 3.2, rendendolo ideale per ambienti in cui la velocità è cruciale. Funziona su GPU consumer, riducendo i requisiti hardware e abbassando i costi operativi. Inoltre, consuma il 40% di energia in meno rispetto ai modelli concorrenti, contribuendo a una maggiore sostenibilità.

Le applicazioni principali includono:

Assistenza clienti avanzata: Llama 4 può rispondere a domande complesse e fornire supporto personalizzato.

Analisi di documenti: Il modello sintetizza rapidamente informazioni da grandi quantità di dati.

Sviluppo software: Aiuta a generare codice e a risolvere problemi tecnici.

Content creation: Produce contenuti di alta qualità per il marketing e la comunicazione.

Queste caratteristiche lo rendono una risorsa preziosa per migliorare l’efficienza e ridurre i costi aziendali.

Applicazioni educative e di ricerca

Llama 4 offre un supporto significativo nel campo dell’educazione e della ricerca. La sua capacità di elaborare testo e immagini lo rende uno strumento versatile per insegnanti, studenti e ricercatori. Ad esempio, può analizzare immagini scientifiche e generare spiegazioni dettagliate, facilitando l’apprendimento visivo.

Nel settore della ricerca, Llama 4 accelera l’analisi di grandi dataset e la sintesi di articoli accademici. Gli educatori possono utilizzarlo per creare materiali didattici personalizzati, mentre gli studenti possono sfruttarlo per ricevere risposte chiare e precise a domande complesse. La sua accessibilità open source garantisce che queste risorse siano disponibili a un pubblico ampio e diversificato.

Esempi di innovazione con Llama 4

Llama 4 ha già ispirato numerosi progetti innovativi. In ambito sanitario, il modello viene utilizzato per analizzare immagini mediche e fornire diagnosi preliminari. Nel settore industriale, supporta la manutenzione predittiva, identificando potenziali guasti prima che si verifichino.

Un esempio interessante riguarda l’uso di Llama 4 nella creazione di contenuti educativi interattivi. Grazie al supporto multimodale, il modello genera quiz visivi e testuali che migliorano l’esperienza di apprendimento. Inoltre, alcune aziende lo utilizzano per sviluppare chatbot avanzati, capaci di comprendere e rispondere a domande complesse in tempo reale.

Questi casi d’uso dimostrano come Llama 4 stia trasformando diversi settori, offrendo soluzioni innovative e accessibili.

Llama 4 rappresenta un modello rivoluzionario che ridefinisce il futuro dell’intelligenza artificiale. La sua combinazione di potenza, accessibilità e innovazione tecnica lo rende una risorsa unica per sviluppatori, aziende e ricercatori.

L’accessibilità open source di Llama 4 garantisce che chiunque possa utilizzarlo, mentre la neutralità nelle risposte promuove un’interazione etica e imparziale.

Meta invita la comunità globale a esplorare Llama 4 e a sfruttarne le potenzialità per progetti innovativi. Questo modello offre infinite possibilità per trasformare idee in realtà.

FAQ

Quali sono le principali innovazioni di Llama 4 rispetto ai modelli precedenti?

Llama 4 introduce finestre di contesto estese fino a 10 milioni di token, supporto multimodale per testo e immagini e un’architettura “Mixture of Experts”. Queste innovazioni migliorano l’efficienza, la precisione e la capacità di gestire dati complessi.

📝 Nota: Queste caratteristiche lo rendono ideale per applicazioni avanzate.

Llama 4 è completamente open source?

Sì, Llama 4 è open source. Meta ha scelto questo approccio per promuovere la collaborazione globale e rendere l’intelligenza artificiale accessibile a tutti. Gli sviluppatori possono personalizzare il modello e contribuire al suo miglioramento tramite piattaforme come GitHub.

Quali sono i vantaggi del supporto multimodale?

Il supporto multimodale consente a Llama 4 di elaborare testo e immagini insieme. Questa capacità migliora l’accessibilità e apre nuove possibilità in settori come la sanità, l’educazione e l’industria.

💡 Suggerimento: Utilizza Llama 4 per analisi visive e testuali integrate.

Come si confronta Llama 4 con GPT-4?

Llama 4 offre finestre di contesto più ampie, costi di inferenza inferiori e accessibilità open source. GPT-4, invece, richiede un abbonamento e ha limiti di contesto più ristretti. Llama 4 è una scelta più economica e versatile per molte applicazioni.

Come posso contribuire allo sviluppo di Llama 4?

Gli sviluppatori possono contribuire segnalando bug, proponendo miglioramenti e collaborando su GitHub. Meta incoraggia la partecipazione globale per migliorare il modello e accelerare l’innovazione.

🌍 Partecipa: Ogni contributo aiuta a costruire un futuro tecnologico più equo.